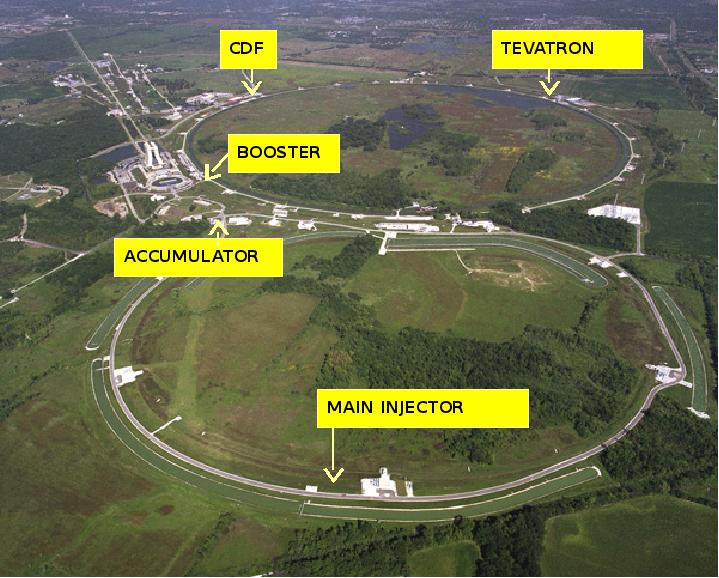

นักวิจัยตีพิมพ์ Paper ใหม่ ๆ ออกมาทุกวัน เหมือนกับนักข่าวที่เขียนข่าวใหม่ ๆ ออกมาทุกวัน แต่มีเรื่องน่าสนใจอย่างหนึ่งที่เราอยากเล่าให้ทุกคนฟัง ในมลรัฐอิลินอยส์ มีเครื่องเร่งอนุภาคซึ่งเป็นเครื่องมือทดลองทางวิทยาศาสตร์ที่ใหญ่มาก ๆ นอนนิ่งอยู่ตั้งแต่ปี 2011 มันถูกปลดระวางเนื่องจากนักฟิสิกส์หันไปใช้เครื่องที่มีขนาดใหญ่กว่า เครื่องนี้ชื่อว่า Tevatron แต่แม้ว่ามันจะถูกเลิกใช้งานมานานเกือบ 10 ปี ทุกวันนี้ยังมีข่าวว่ามันทำให้เกิดการค้นพบใหม่ ๆ เรื่อย ๆ เพราะอะไร ? มันปิดไปแล้วไม่ใช่เหรอ ? คำตอบก็คือสิ่งที่เรียกว่า Event

ในการเดินเครื่องแต่ละครั้ง เวลาที่มีการชนกันของอนุภาคเราจะนับว่าเป็น Event ซึ่งแน่นอนว่าเกิด Event ขึ้นเป็นพันล้านครั้ง ในขณะที่ข้อมูลในแต่ละ Event ก็จะถูกบันทึกลงใน Data Center ขนาดใหญ่ คำตอบของคำถามด้านบนก็คือ เพราะ Paper นั้นไม่ได้เขียนขึ้นมาจาก Event เพียงครั้งเดียว หรือจาก Event ครั้งล่าสุด แต่มันเกิดจากการประมวลผล หรือ Analyze Data ขนาดมหาศาล ที่เกิดขึ้นแล้ว นั่นทำให้มันเกิดการค้นพบใหม่ ๆ แม้ว่าตัวเครื่องจะเลิกใช้ไปแล้วก็ตาม

เหตุการณ์แบบนี้เกิดขึ้นกับยานอวกาศเหมือนกัน มีการตีพิมพ์การค้นพบจากข้อมูลของยานอวกาศที่เชื้อเพลิงหมดไปแล้วเป็นเรื่องปกติ เพราะเรามองว่ามันคืออุปกรณ์ในการรับข้อมูล และเราก็เอาข้อมูลที่ได้และเก็บไว้มาใช้ ไม่ว่าจะเป็นศาสตร์เชิงสถิติ การหาความเชื่อมโยง การหาแนวโน้มต่าง ๆ ซึ่งมันคือการเอาความรู้เรื่องการเขียนโปรแกรมมาใช้

น่าจะพอเห็นภาพแล้วว่า Data นั้นสร้างขึ้นไม่ได้ยาก แต่ความยากมันคือการเอา Data นั้นมาวิเคราะห์แล้วสังเคราะห์เป็นข้อมูลใหม่ ๆ ขึ้นมา ซึ่งอันนี้เป็นเรื่องปกติในวงการวิทยาศาสตร์ แล้วในวงการนักสื่อสารมวลชนละ ? มี Case-study แบบนี้ไหม

คำตอบก็คือมี ถ้ายังจำกรณีของ Panama Paper ที่เป็นเหตุการณ์ที่ทำให้ทั่วโลกได้ตระหนักถึงความสำคัญของ Data Journalism เลยก็ว่าได้ คงเป็นเรื่องปกติที่ข้อมูลจากเอกสารแผ่นหนึ่งที่ส่อถึงการคอรัปชั่นจะหลุดไปถึงมือนักข่าวแล้วนักข่าวเอามาเปิดโปง (เรื่องปกติของพล็อตหนังนักข่าว) แต่ Panama Paper ไม่ใช่แบบนั้น มันเกิดจากการวิเคราะห์ข้อมูลจำนวน 2.6 Terabyte ซึ่งเป็นไปไม่ได้เลยที่นักข่าวจะมานั่งอ่านทีละแผ่น แต่ด้วยการวิเคราะห์หา Pattern บางอย่าง ทำให้ข้อมูลชุดนี้ เผยให้เห็นการซุกซ่อนเงินและหลีกเลี่ยงภาษีจำนวนมหาศาล และทำให้นายกไอซ์แลนด์ต้องลาออกเลยทีเดียว ทั้งหมดนี้จะไม่เกิดขึ้นถ้าเราไม่รู้จักกับคำว่า Big Data และ การเขียนโปรแกรม (Programming)

ทำไมต้องเขียนโปรแกรม

ลองย้อนไปในยุคสมัยก่อน ก่อนจะมีคอมพิวเตอร์ เราไปถามนักคณิตศาสตร์ว่า ค่าพายหาอย่างไร นักคณิตศาสตร์ก็จะตอบได้ไม่ยากว่าก็เอา 22 หาร 7 แต่ถ้าเราถามเขาว่า แล้วค่าพายตำแหน่งที่สองร้อยล้านคืออะไร นักคณิตศาสตร์ก็อาจจะด่าเราได้ แต่ถ้ามาสมัยนี้ เราไปถามนักคณิตศาสตร์ด้วยคำถามเดิม เขาก็ตอบได้ไม่ยาก แถมไม่ต้องเป็นนักคณิตศาสตร์ด้วย เด็กประถมก็ตอบได้ เพราะเราก็แค่เขียนโปรแกรม บอกคอมพิวเตอร์ว่าให้เอา 22 หาร 7 ไปเรื่อย ๆ สองร้อยล้านครั้ง แล้วดูเลขตัวท้ายนั้นก็รู้แล้ว จะเห็นว่า คนเราไม่ได้ฉลาดขึ้นว่ามีสูตรสมการที่ทำให้การหาค่าพายตำแหน่งที่ n ได้ แต่เพราะว่าเรารู้จักการเขียนโปรแกรมต่างหาก

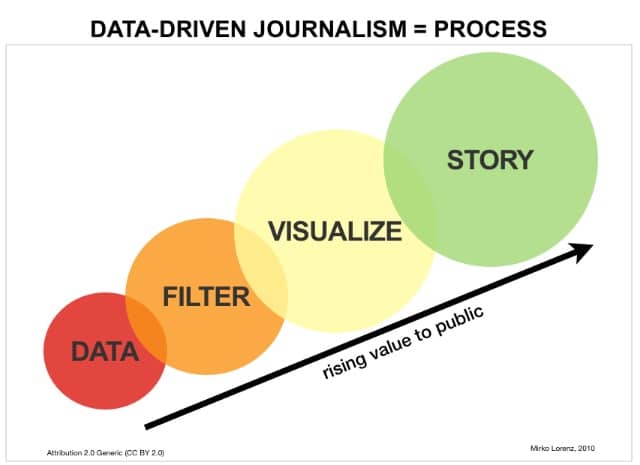

ดังนั้น มองในโลกของ Journalism โลกนี้มี Data ต่าง ๆ มากมายที่เราอาจจะเอามารายงาน แต่เป็นแค่กระจกสะท้อนมันเท่านั้น ไม่ได้สังเคราะห์อะไรออกมาใหม่ การเอาความสามารถด้านการเขียนโปรแกรมมาช่วยก็จะทำให้เราสามารถสร้าง “อัลกอริทึม” ที่นำข้อมูลเหล่านี้มาวิเคราะห์ หรือถ้าในยุคนี้ คงไม่มีใครไม่เคยได้ยินคำว่า Machine Learning ที่เราแค่ป้อนข้อมูลไปให้มัน มันก็จะหา Pattern ความเชื่อมโยงบางอย่าง

วิธีคิดแบบนัก Data Journalist ง่าย ๆ

มาลองดูวิธีคิดแบบ Data Journalist แบบง่าย ๆ กันดู

- รายงานแบบปกติ นาย A มีส้มโอ 3 กล่อง แต่ละกล่องมี 2 ลูก

- รายงานแบบใช้อัลกอริทึม นาย A มีส้มโอ 3 กล่องแต่ละกล่องมี 2 ก็คือให้เอา 2+2+2 = 6 นาย A มีส้มโอ 6 ลูก

- รายงานแบบ Machine Learning นาย C เห็นนาย A มีส้มโอ 6 ลูก มี 3 กล่อง, นาง B มีส้มโอ 2 ลูก, นาย A และนาง B ซื้อส้มโอมาจากร้านเดียวกัน เราจึงรายงานว่า ร้านค้านี้ขายส้มโอกล่องละ 2 ลูก แต่นาง B ซื้อแค่กล่องเดียว

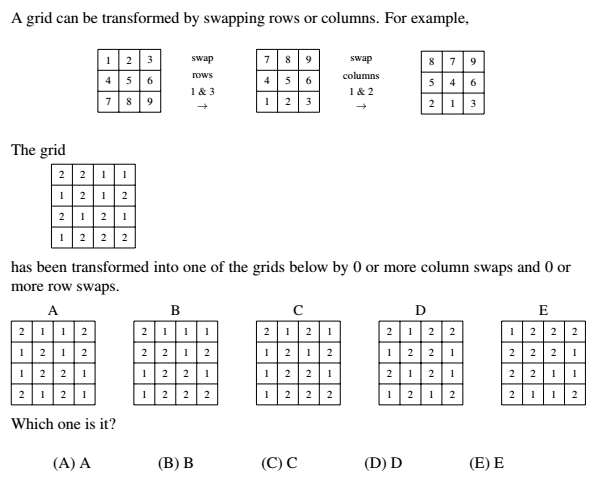

เราจะบอกว่า ทั้งสองแบบล่าง รายงานด้วย Data ก็ได้ ซึ่งตัวอย่างที่ยกมาอาจจะเหมือนง่าย แต่ลองนึกภาพดูว่าถ้าเลขมันไม่ใช่ 2 หรือ 6 แต่เป็นจำนวนที่เยอะมาก ๆ หรือเป็น Matrix อะไรแบบนี้ เราจะไม่สามารถคิดง่าย ๆ เร็ว ๆ ได้เลย

ทั้งนี้ Data จะเป็น Input หรือ Output ก็ได้ แต่สิ่งที่เราจะหาก็คือ Process ถ้าเรารู้ Input และ Output แปลว่าเราต้องหา Process, ถ้าเรารู้ Input และ Process แปลว่าเราต้องหา Output และถ้าเรารู้ Process กับ Output แปลว่าเราต้องหา Input

ซึ่ง Machine Learning ที่พูด ๆ กันมันก็คือเทคนิคใหม่ที่เอาไว้หา Process จาก Input กับ Output นั่นเอง (ที่ยากเพราะเราต้องหา pattern) อย่างกรณีด้านบนคือ เราหา pattern ได้จากการที่ไปซื้อร้านเดียวกัน แล้วมีกล่องไม่เท่ากัน เลยรู้ว่าร้านใส่ส้มโอ 2 ลูกใน 1 กล่อง

กระแส Data Journalist รอบตัวเรา

น่าจะพอเห็นภาพของความสำคัญของ Data กันไปแล้ว ทีนี้เราจะมาลองดูกรณีตัวอย่างว่า การทำ Data Journalist ในไทยมีแบบไหนได้บ้าง ซึ่งจริง ๆ กระแสนี้มีที่มาตั้งแต่ 2-3 ปีก่อน ซึ่งเราจะได้ยินคำว่า Data Journalist คู่กับ Data Visualization ซึ่ง Data Visual นั้น มาแรงแบบฉุดไม่อยู่จริง ๆ ก็คงจะหนีไม่พ้น รู้สู้ Flood ตอนน้ำท่วมปี 2011 ที่พากระแส Infographic เข้ามาในไทย ส่วน Data Journalist นั้น เนื่องจากเป็น process เราจึงอาจจะดูยากนิดนึงว่าอันนี้เป็นวิธีคิดแบบ Data Journalist แต่เราจะดูผลของมันมากกว่า (ซึ่งผลที่ได้ส่วนมาก็จะถูกเอามาย่อยเป็น Visual อีกที เพื่อให้คนทั่วไปเข้าใจง่าย)

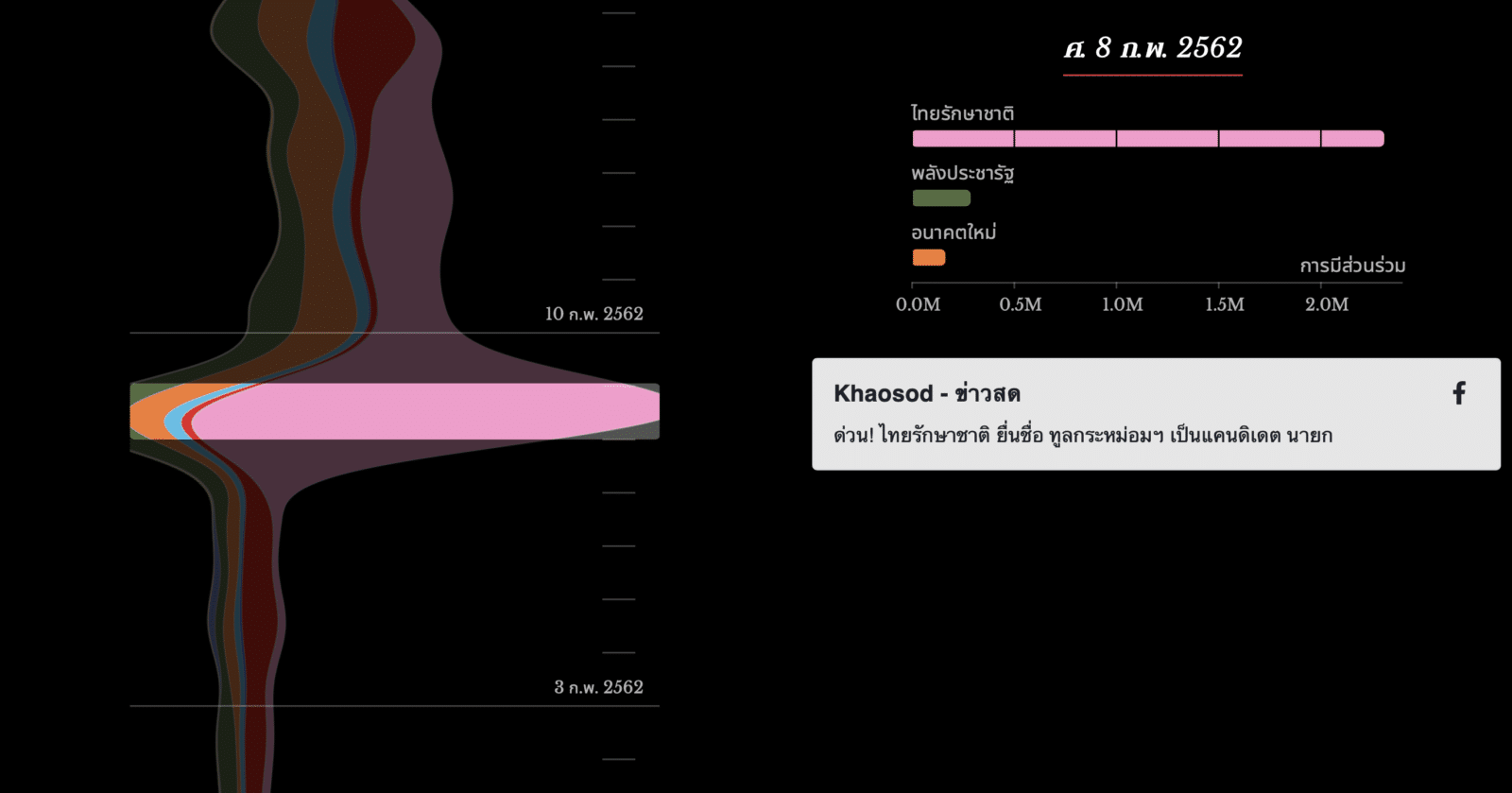

พูดยากว่า Data Journalist เข้ามาในไทยตอนไหน เพราะก็ค่อย ๆ พัฒนาขึ้นมา แต่ถ้าถามว่า Data Journalism ยอดฮิตช่วงนี้คืออะไร คงต้องบอกว่าเป็นเรื่องเกี่ยวกับการเลือกตั้ง ยกตัวอย่างการที่ The MATTER จับมือกับ Boonmelab เปิดตัว Elect.in.th เว็บไซต์รวมเรื่องราวเกี่ยวกับการเลือกตั้งที่ไม่ใช่แค่เล่าข่าว แต่บอกว่าข่าวนั้นบอกอะไรกับเราบ้าง

มีอันนึงที่น่าสนใจมากคือ วิเคราะห์ศึกเลือกตั้งบนโลกโซเชียล ที่เป็นการเก็บ Data จาก Message ที่คนพูดถึงบน Social Media ว่าพรรคไหนกำลังมาแรงเป็นที่คนสนใจ ซึ่งแยกออกมาให้เราดูเป็น Event ต่าง ๆ ตามด้วยกราฟที่บวมตามจำนวนที่คนพูดถึง ก็ทำให้เราสามารถสรุปเป็นประเด็นต่าง ๆ ออกมาได้จาก ข้อมูลที่รวบรวมมา

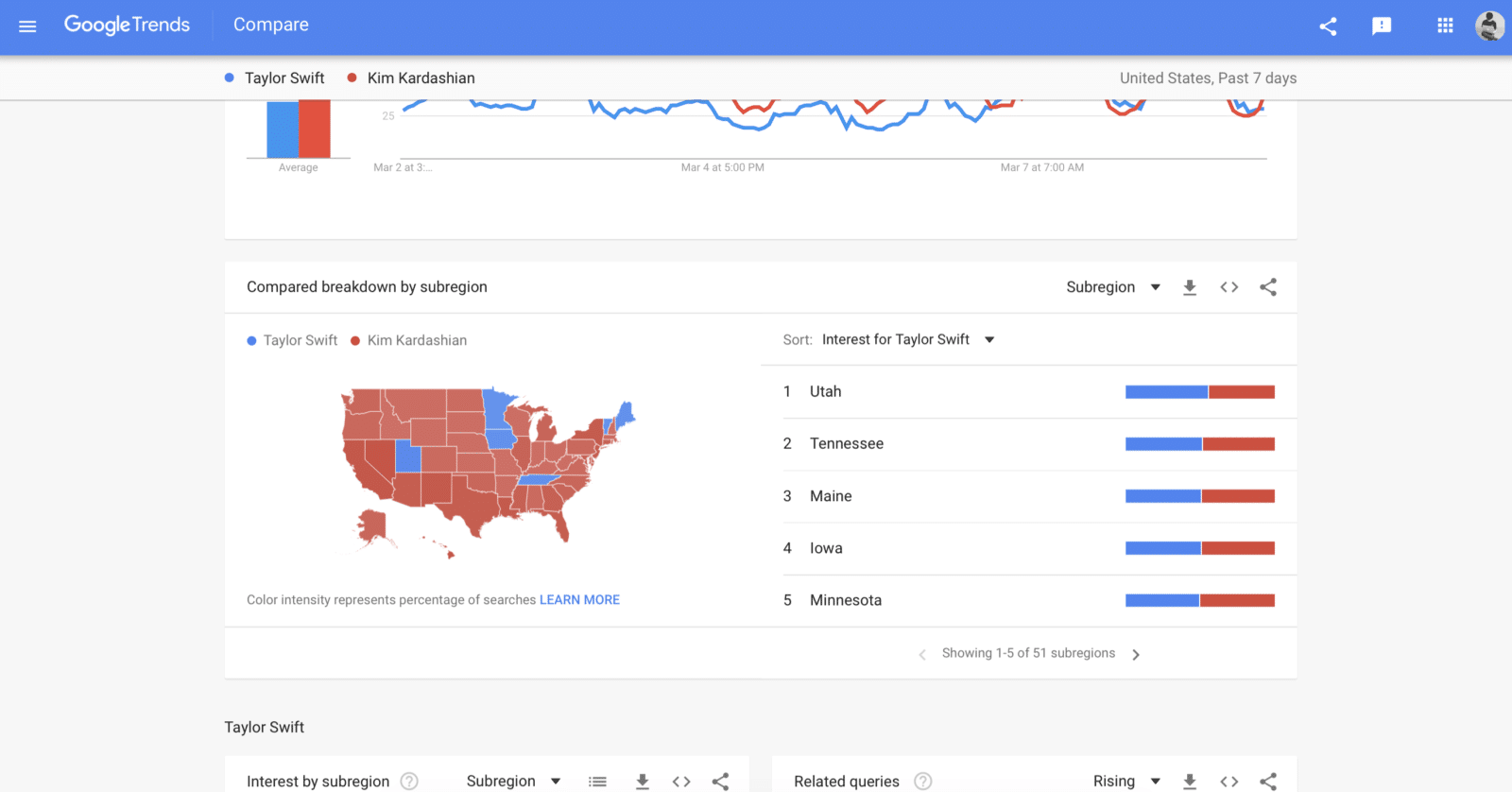

หรือแบบเอาง่าย ๆ เลย Data Journalism ที่เล่นสนุก ๆ ที่หลายคนน่าจะเคยเล่นก็คือ Google Trend นั่นแหละ

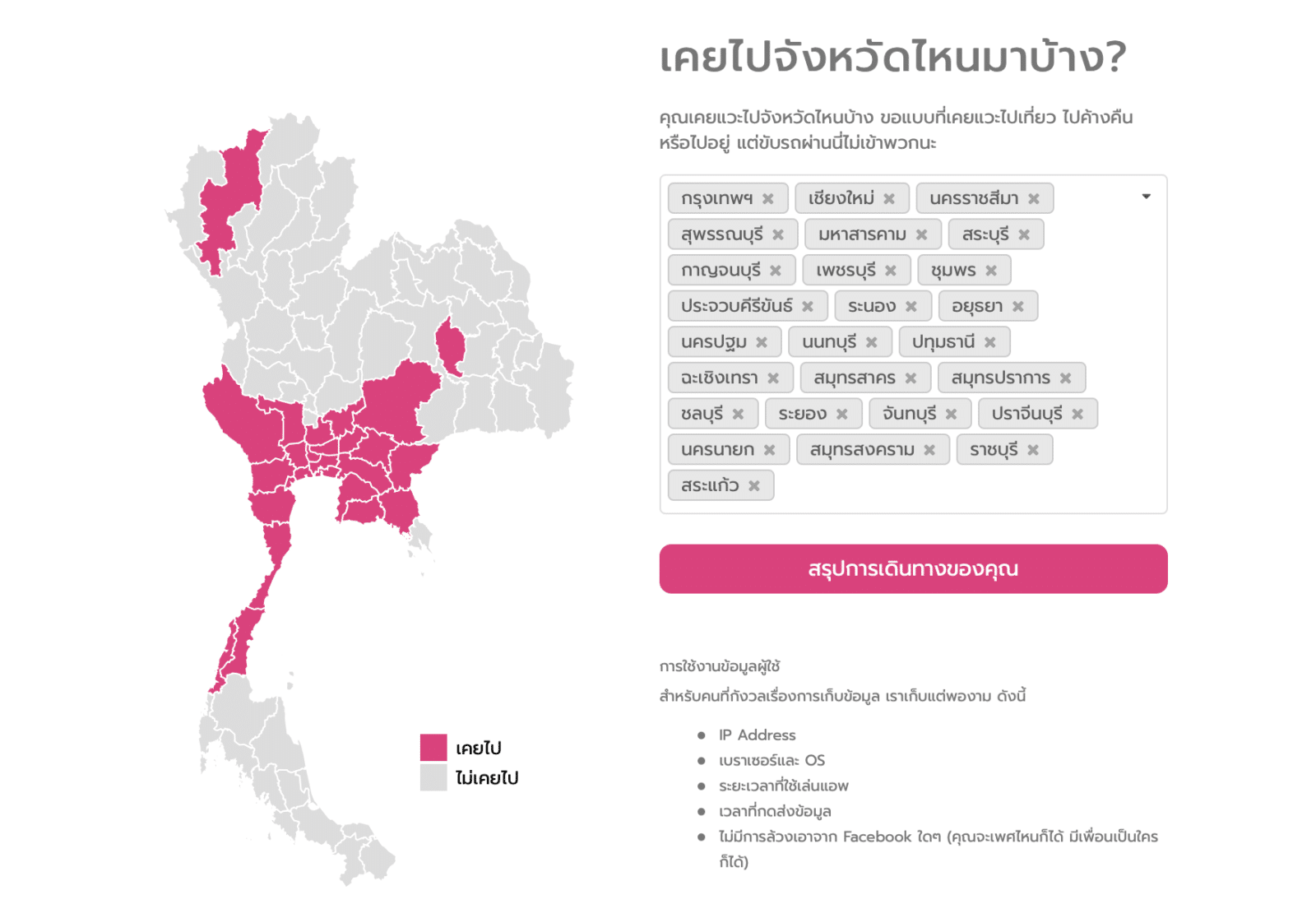

หรือถ้ายังจำเกมที่ให้คนมาเล่นเรื่องว่าเคยไปจังหวัดไหนบ้างได้ไหม ? อันนั้นจริง ๆ แล้วคนทำไม่ได้ทำมาเล่น ๆ สนุก ๆ แต่มันคือการเก็บ Data สุดท้ายมันจะกลายมาเป็นข้อมูลว่าคนไทยจังหวัดนี้ ๆ เคยไปไหนบ้าง หรือ คนกรุงเทพชอบไปภาคเหนือ คนเหนือเกิดครึ่งไม่เคยไปทะเล (สมมติเอา) อะไรแบบนี้ ซึ่งบ่งบอกอะไรเรามากกว่าการรายงานแบบเดิม ๆ

จะเห็นว่า ณ ตอนนี้ Data Journalism ในไทยยังกอง ๆ อยู่ที่ Social Media ซะส่วนมาก เพราะเขียนโปรแกรมมาเก็บข้อมูลได้ง่าย นั่นทำให้เราจึงจำเป็นต้องผลักดันให้ภาครัฐเปิด Open Data ที่เข้าถึงได้ง่ายเยอะ ๆ และต้องให้เรา ๆ นี่แหละมาช่วยกันวิเคราะห์ข้อมูลเพื่อสะท้อนอะไรบางอย่างของสังคมมา ซึ่งมันคือบทบาทของนักข่าวอยู่แล้วในการทำหน้าที่เปิดเผยสิ่งที่เกิดขึ้นในสังคม การนำเสนอข่าวนั้น ยากขึ้นตามเทคโนโลยี ถ้านักข่าวยังแค่บอกว่า ใคร ทำอะไร ที่ไหน อย่างไร แค่นั้นก็อาจจะทำให้เราไม่ต่างจากคนธรรมดาที่ทุกวันนี้ก็เล่น และเล่าเรื่องผ่าน Social Media ได้ (จะสังเกตว่าช่วงนี้ข่าว Social เยอะมาก เพราะการทำข่าวแบบนี้ไม่ยาก แค่ก็อปลิ้งค์หรือแคปจอมาแปะ)

Data Journalism ความท้าทายอยู่ตรงที่ว่า เราต้องเอาวิธีคิดใหม่ ๆ เขาไปจับกับการรายงานเดิม ๆ ในขณะที่หลายฝ่ายต้องวิ่งเข้าหากันและเข้าใจซึ่งกันและกัน ทั้งภาคธุรกิจ + รัฐบาล + ประชาชน + นักข่าว + นักคอมพิวเตอร์ เพื่อช่วยกันสะท้อนสิ่งที่เกิดขึ้นในสังคมออกมา และแก้ปัญหาอะไรบางอย่างร่วมกัน ใครว่า Journalism กำลังจะตาย ผู้เขียนไม่เชื่อ แต่ Journalism ที่ไม่ได้ให้ Value หรือใคร ๆ ก็ทำได้ต่างหากที่กำลังจะตาย

เรียบเรียงโดย ทีมงาน RAiNMAKER