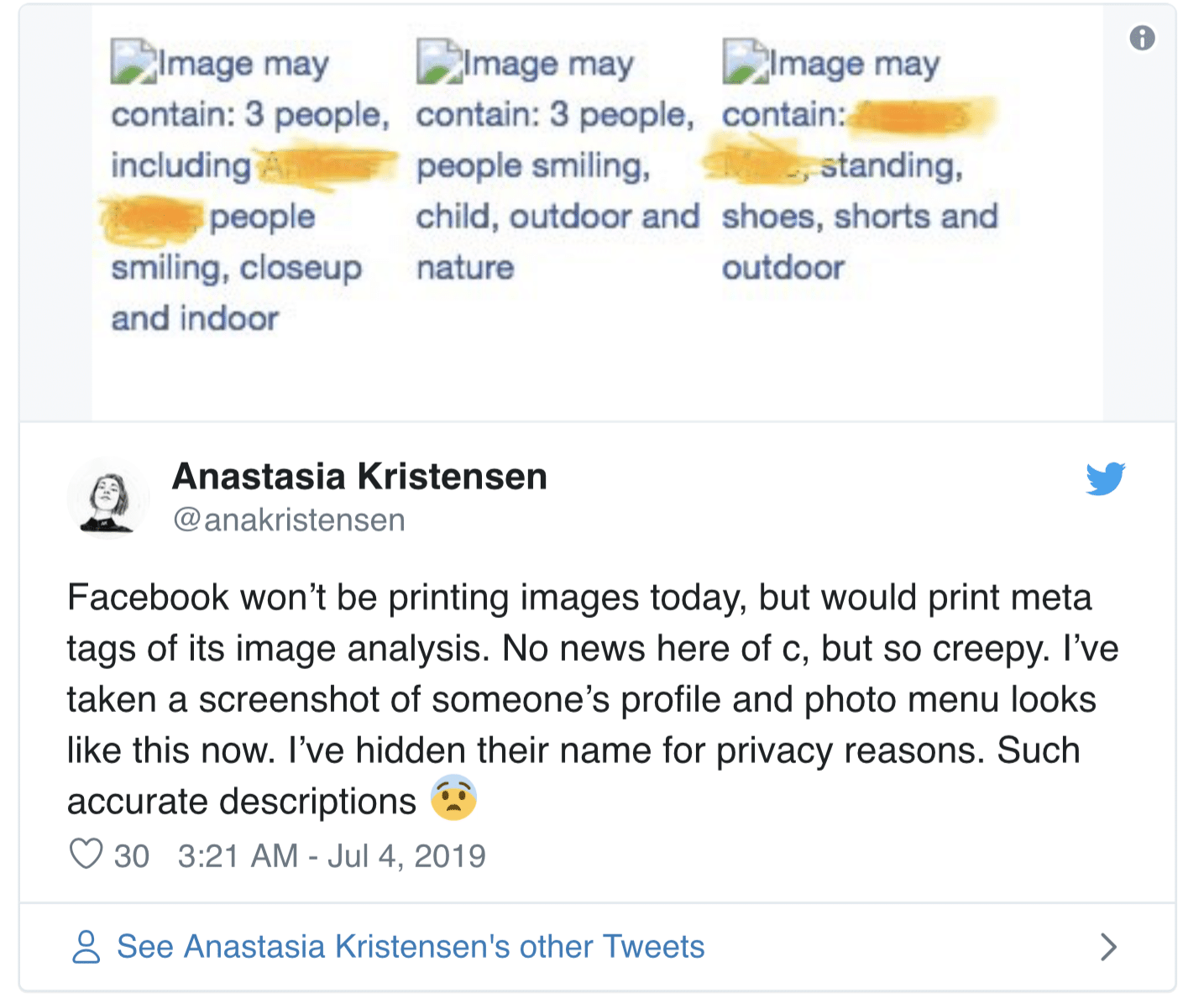

เมื่อวันที่ 4 กรกฎาคมที่ผ่านมาทั่วโลกก็ได้เจอกับวิกฤติ Facebook ล่มกันอย่างพร้อมหน้าเพราะเกิดจากระบบ CDN ซึ่งเป็น ซึ่งโดนด่าเรื่องล่มไม่พอแล้ว Facebook ยังโดนเล่นประเด็นเรื่องข้อความที่ปรากฎขึ้นตอนที่ภาพไม่โหลด ซึ่งเป็นคำบรรยายของภาพที่เกิดจากการนำโมเดล Machine Learning มาเดาว่าสิ่งที่อยู่ในภาพคืออะไร วัตถุ หรือคน แล้ววิเคราะห์ออกมาเป็นคำ ด้วยคำว่า Image may contain:

ซึ่งบางเว็บไซต์ก็ถึงขั้นใช้คำว่า “น่าเกลียดน่ากลัว” ในการบรรยายสิ่งที่เกิดขึ้น คือการวิเคราะห์ภาพถ่าย หรือมีการแคปหน้าจอต่าง ๆ ที่ขึ้นข้อความเหล่านี้ไปพูดถึงในเชิงว่าเป็นสิ่งที่น่ารังเกียจมาก ๆ และพูดกันในเชิงลบบอกว่า Facebook กำลังละเมิดความเป็นส่วนตัวอยู่ หรือกำลังมีแผนอะไรบางอย่าง

แต่จริง ๆ แล้ว ถ้าใครที่เขียนโปรแกรมหรือมีความรู้ด้านเทคโนโลยีเว็บจะรู้ว่าระบบพวกนี้ การวิเคราะห์ภาพถ่าย การเดาบุคคล มันเกิดขึ้นที่หลังบ้านหมด แล้ว Facebook จะเขียนโค้ดมาให้แสดงที่ front-end ซึ่งเป็นหน้าเว็บ HTML ปกติทำไม คำตอบก็คงเป็นอย่างอื่นไปไม่ได้นอกจากว่า Facebook ต้องการที่จะให้เรารู้นี่แหละว่าในภาพมีอะไรบ้าง

ปกติแล้วจะมีระบบการอ่านข้อความบนหน้าจอซึ่งถูกใช้สำหรับผู้ที่มองไม่เห็น เป็นฟีเจอร์จำพวกตัวช่วยการเข้าถึงจำพวกนึง ซึ่งปกติพวกข้อความที่เป็น Text นั้นระบบจะอ่านได้ตามปกติ แต่พอเป็นรูป ถ้าไม่มีการวิเคราะห์ภาพด้วยโมเดล Machine Learning เราก็จะไม่สามารถอธิบายสิ่งที่อยู่ในภาพได้

ดังนั้นสาเหตุที่ Facebook นำข้อความเหล่านี้มาโชว์ที่หน้า HTML ปกติ ก็เป็นแคปชั่นของภาพ ซึ่งปกติเราจะต้องเขียนไว้ใน tag alt ของภาษา HTML เพื่ออธิบายว่ารูปนี้คืออะไร แต่ในเมื่อภาพบน Facebook นั้นเกิดจาก user อัพโหลดขึ้นมาเอง ไม่ได้เหมือนใน Blog หรือเว็บไซต์ การนำระบบเดาภาพมาแสดงข้อความ alt เพื่ออธิบายรูปภาพ ก็ดูจะเหมาะสมสำหรับคอมพิวเตอร์หรือ Browser ที่มีตัวช่วยด้านการเข้าถึงด้วยการบรรยยายภาพ สำหรับผู้ที่สายตามองไม่เห็นนั่นเอง

คำถามก็คือ เราตัดสินเทคโนโลยีเกินไปหรือเปล่า

จริงอยู่ที่ว่าเทคโนโลยีทุกวันนี้นั้นดูน่ากลัวและละเมิดความเป็นส่วนตัว แต่ถามว่ากรณีนี้นั้นเราสามารถเอาข้อผิดพลาดที่ Facebook เคยทำไว้ในอดีต (กรณี Cambridge Analytica) มาตัดสินบอกว่า Facebook นั้นน่ารังเกียจ หรือเทคโนโลยีการวิเคราะห์ภาพถ่ายนั้นน่ารังเกียจ มันยุติธรรมสำหรับ Facebook เองแล้วจริงเหรอ

คำถามต่อไปก็คือเราอัพโหลดรูปภาพพวกนั้นขึ้นไปบน Facebook เองเพื่อแสดงให้คนบน Facebook ดู แล้วการที่ Machine Learning จะมาเดาว่าในภาพมีอะไรบ้างนั้น เป็นความน่ารังเกียจอย่างไร และถ้าใช้ตรรกะเดียวกัน แบบนี้แสดงว่าเทคโนโลยีที่เราใช้กันอยู่เช่น ระบบจำใบหน้าบน Facebook, Google Photos (และ Apple ที่บอกว่าประมวลผลบน Offline ไม่มีการอัพข้อมูลขึ้น Server) นั้นน่ารังเกียจเหมือนกรณีนี้ด้วยหรือเปล่า

สุดท้ายแล้วสิ่งที่เราอาจจะต้องเตือนตัวเองอยู่เสมอคือ เราต้องพยายามหาทางให้เทคโนโลยีกับตัวเราอยู่ร่วมกันได้บนบรรทัดฐานแห่งจริยธรรม โดยที่อย่าลืมว่าเทคโนโลยีนั้นถูกสร้างขึ้นมาเพื่ออำนวยความสะดวกให้กับมนุษย์ ดังนั้นมันไม่ควรถูกตกเป็นจำเลยของสังคมหรือถูกตัดสินจากการมองอะไรด้านเดียว ทั้ง ๆ ที่มันก็แค่ทำหน้าที่ของมันตามที่ออกแบบไว้เท่านั้นเอง